Xorbits Inference

官网:GitHub - xorbitsai/inference

官方介绍:Xorbits Inference(Xinference)是一个性能强大且功能全面的分布式推理框架。可用于大语言模型(LLM),语音识别模型,多模态模型等各种模型的推理。通过 Xorbits Inference,你可以轻松地一键部署你自己的模型或内置的前沿开源模型。无论你是研究者,开发者,或是数据科学家,都可以通过 Xorbits Inference 与最前沿的 AI 模型,发掘更多可能。

官方文档:欢迎来到 Xinference! — Xinference

运行环境:Ubuntu 22.04 + Intel(R)Xeon(R) CPU E5-2699 v4 2.20GHZ + RAM(512GB)

前期准备

下载项目

2024-04-09 这里下载的是

虚拟环境和依赖

# 创建虚拟环境并激活

python3 -m venv venv

source ./venv/bin/activate

# 安装依赖

pip install "xinference[all]"

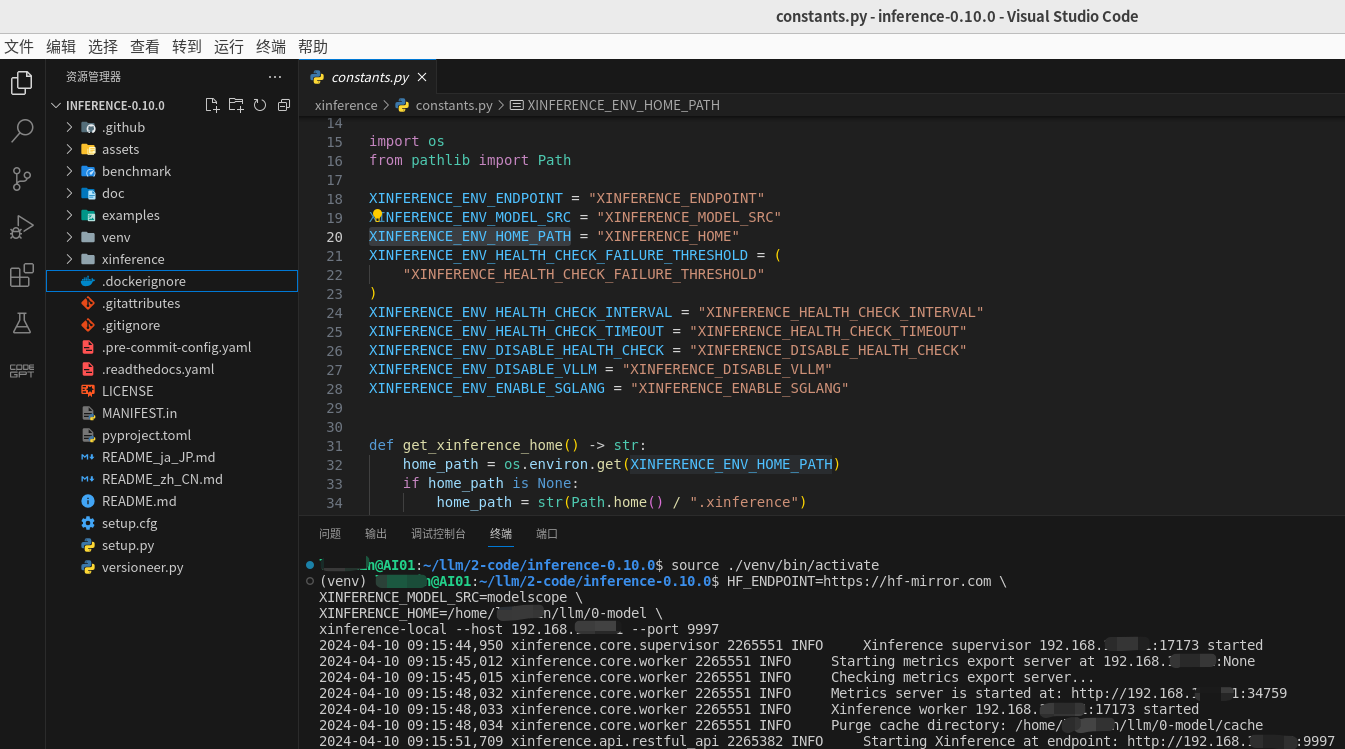

运行 Xinference

上面准备好后就可以启动了,启动命令如下:

HF_ENDPOINT=https://hf-mirror.com \

XINFERENCE_MODEL_SRC=modelscope \

XINFERENCE_HOME=/home/xxx/llm/0-model \

xinference-local --host 192.168.xxx.xxx --port 9997

环境变量或者更多参数请参考官方文档

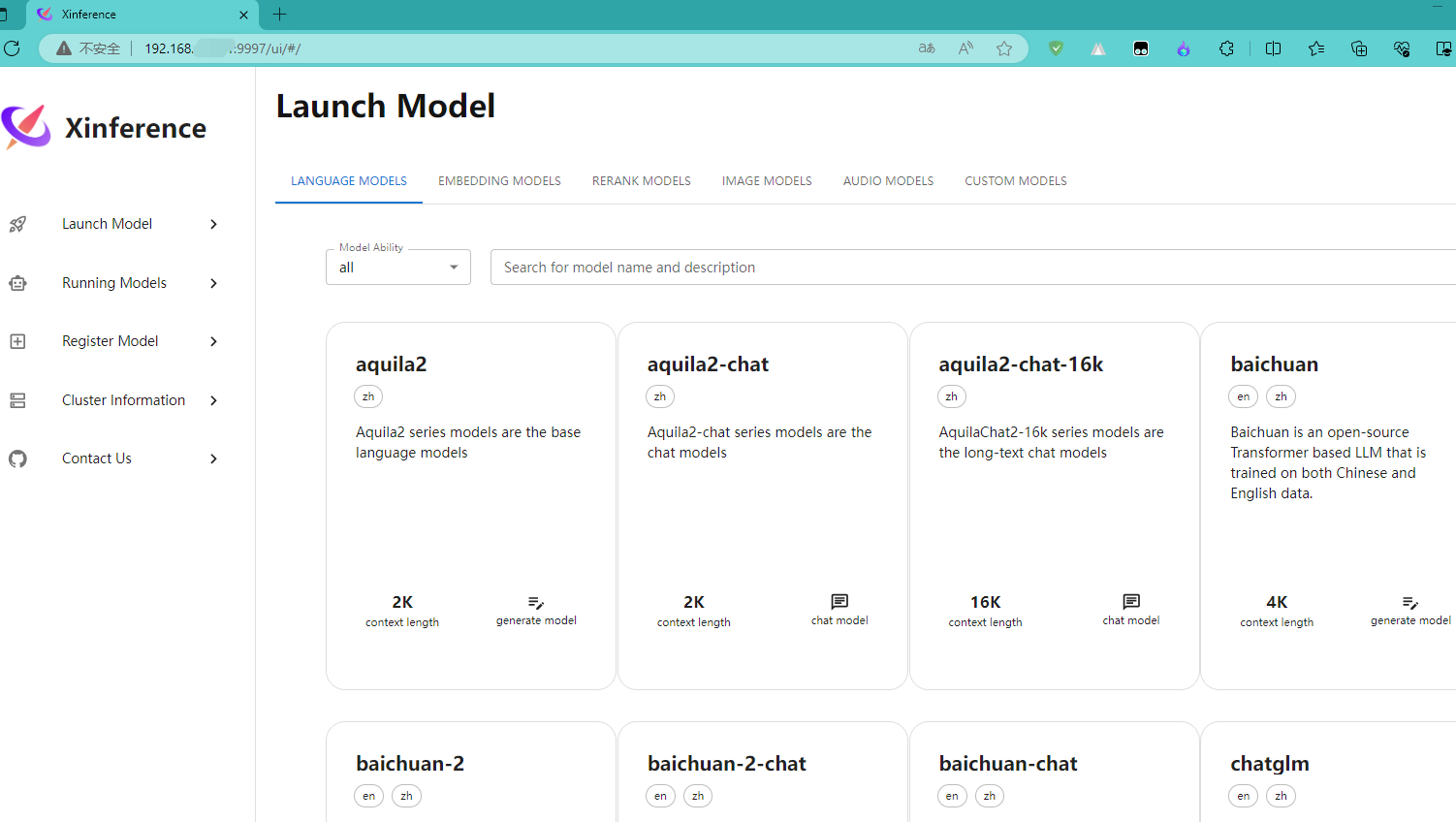

接着我们再看一下Web 页面的效果,如下:

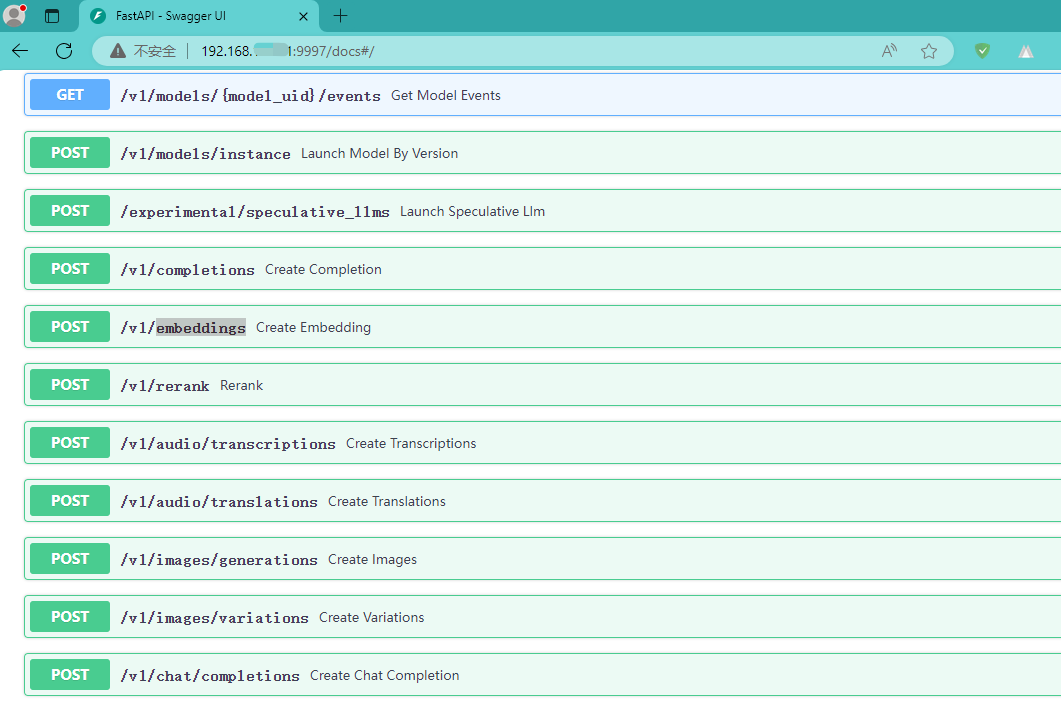

让我们再看一下他的接口文档页面,看一下都提供了哪些接口:

一键脚本启动

创建一个sh脚本,这里命名为

#!/bin/bash

# 打开一个新的终端,并指定终端窗口标题

gnome-terminal --title 'Xorbits Inference' --working-directory=/home/xxx/llm/2-code/inference-0.10.1 -- /bin/bash -c 'source ./venv/bin/activate;

HF_ENDPOINT=https://hf-mirror.com \

XINFERENCE_MODEL_SRC=modelscope \

XINFERENCE_HOME=/home/xxx/llm/0-model \

xinference-local --host 192.168.xxx.xxx --port 9997'

exit

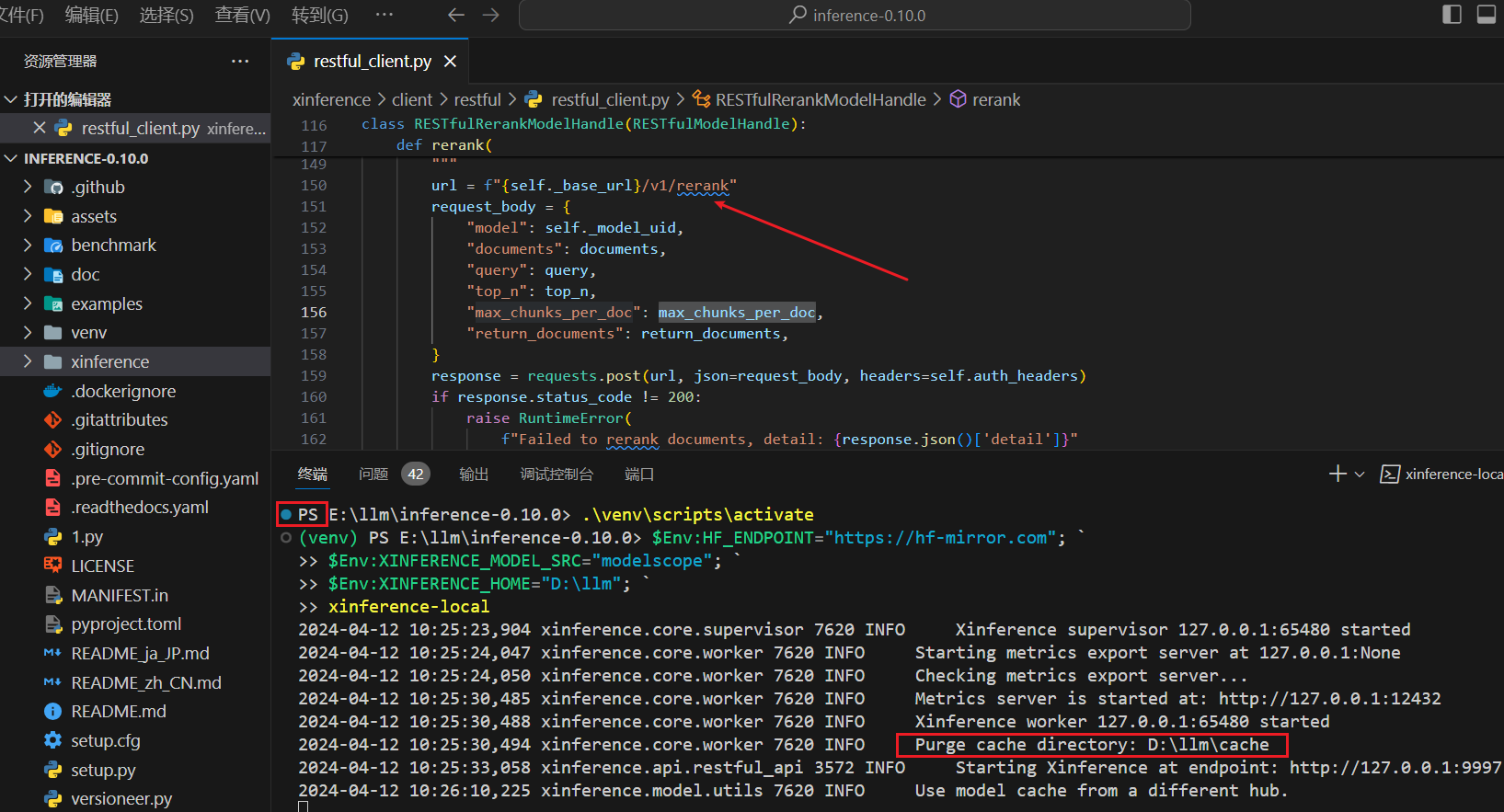

Windows 环境

插一脚。不纯粹了,大环境是

# 创建虚拟环境并激活

python -m venv venv

.\venv\scripts\activate

# 安装依赖(根据电脑的实际情况安装)

pip install "xinference[transformers]"

# 启动

$Env:HF_ENDPOINT="https://hf-mirror.com"; `

$Env:XINFERENCE_MODEL_SRC="modelscope"; `

$Env:XINFERENCE_HOME="D:\llm"; `

xinference-local

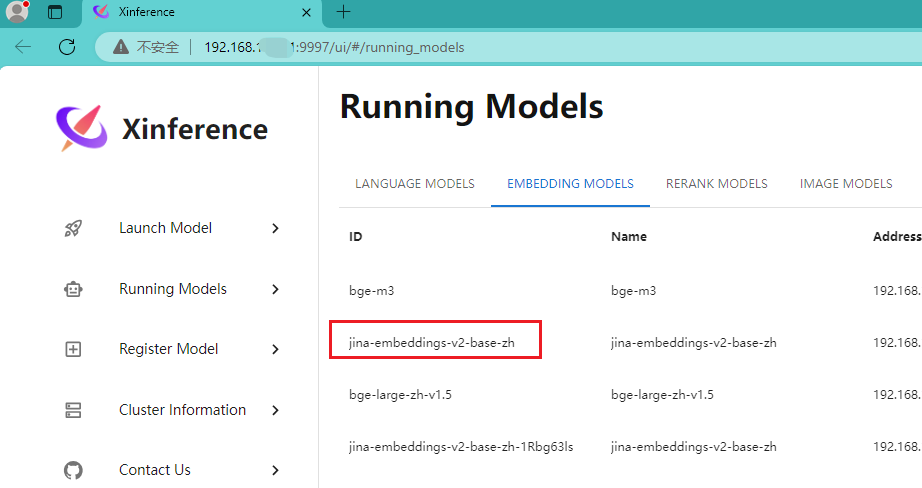

Embedding 模型

已经下载了几个

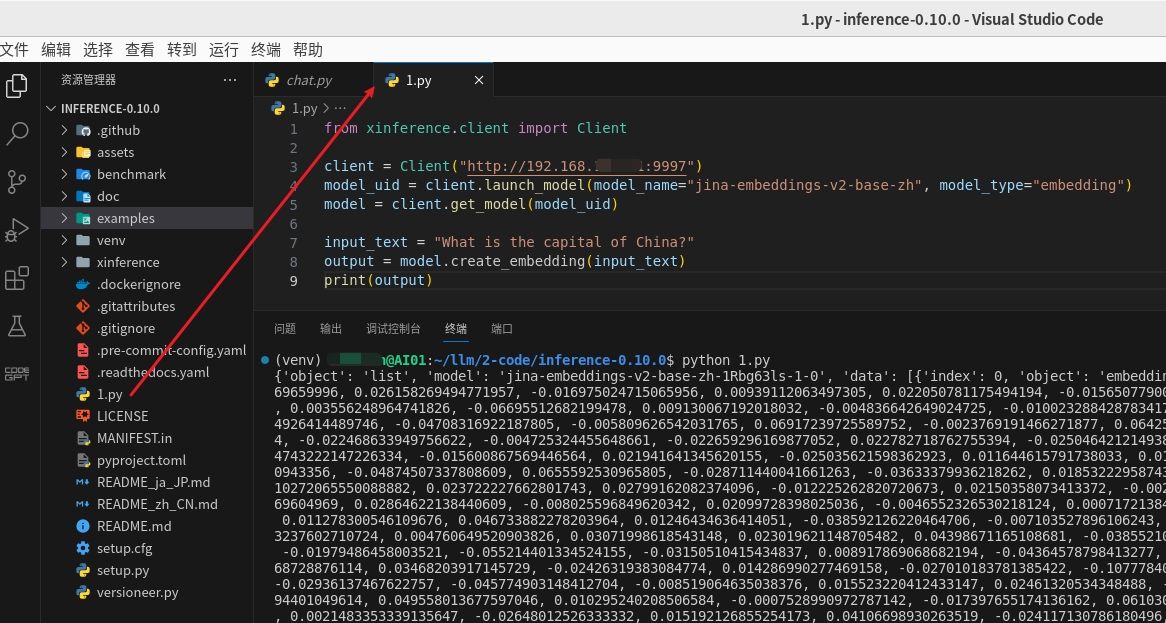

xinference.client

下面的代码来自:客户端 API — Xinference

这里采用

from xinference.client import Client

client = Client("http://192.168.xxx.xxx:9997")

model_uid = client.launch_model(model_name="jina-embeddings-v2-base-zh", model_type="embedding")

model = client.get_model(model_uid)

input_text = "What is the capital of China?"

output = model.create_embedding(input_text)

print(output)

运行结果如下图:

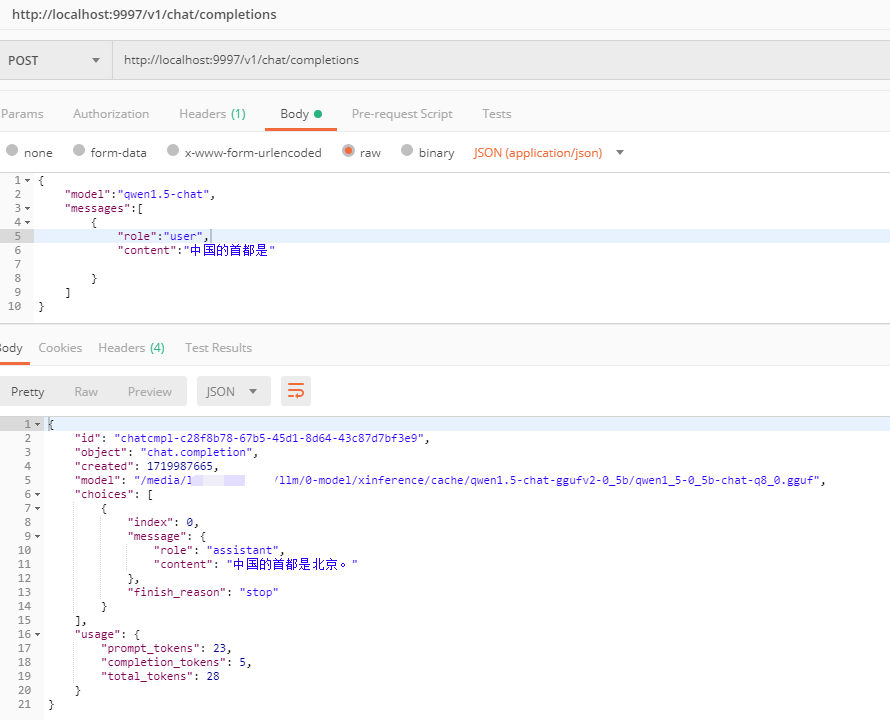

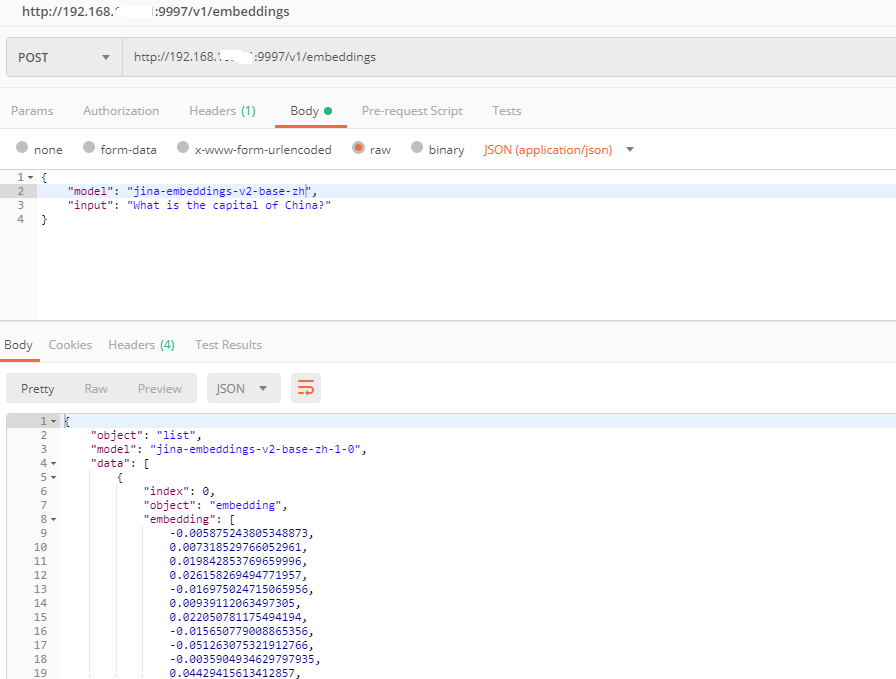

Postman

再使用

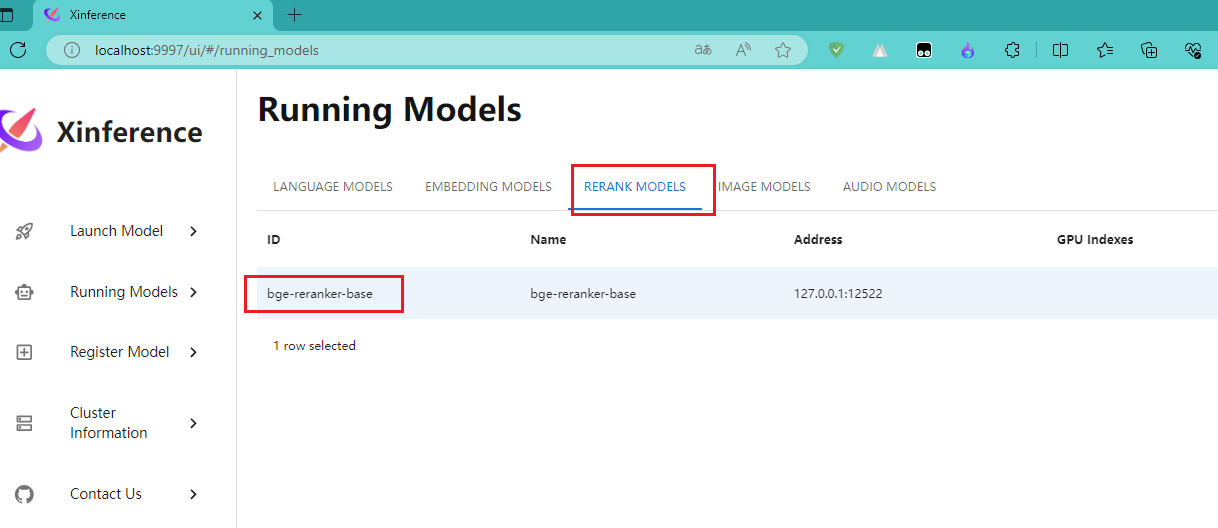

Rerank 模型

已经下载并运行的

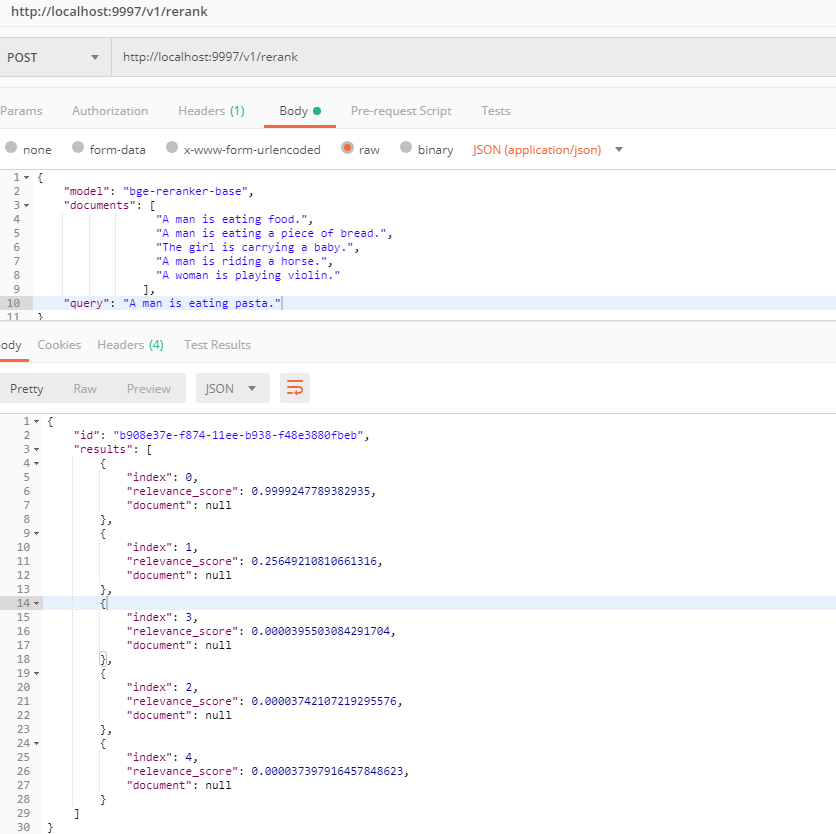

Postman

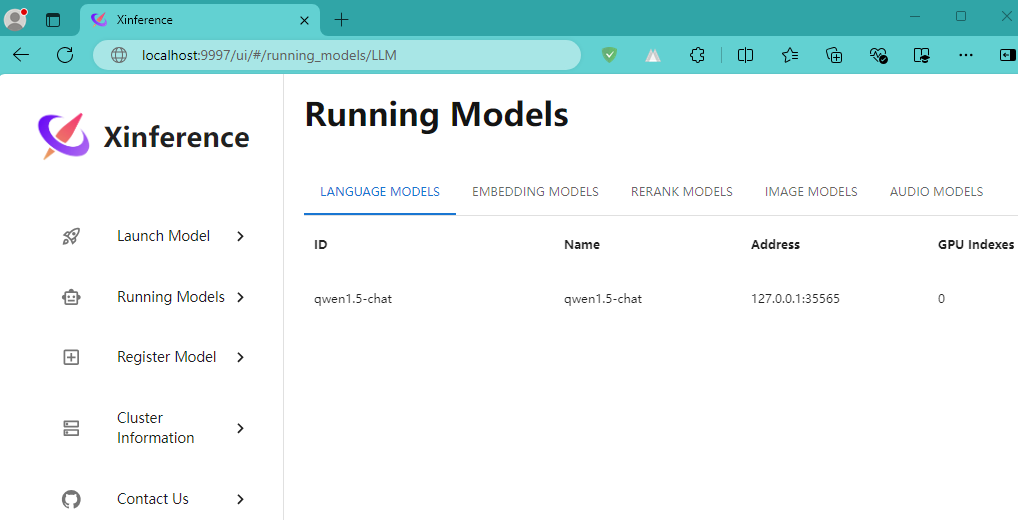

LLM 模型

已经下载并运行的大语言模型,如下图:

Postman